SMXH100GPU促销

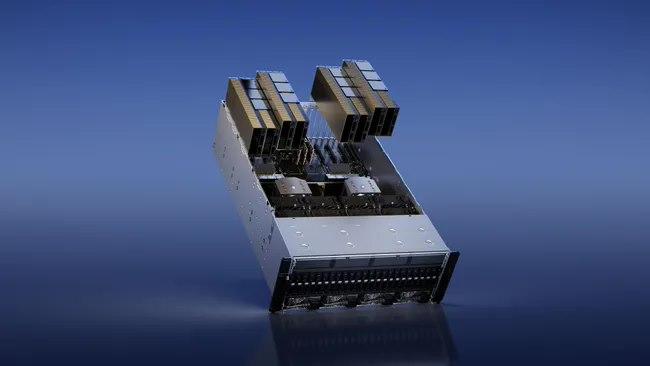

他们与英伟达合作托管了一个基于NVIDIA的集群。Nvidia也是Azure的客户。哪个大云拥有好的网络?#Azure,CoreWeave和Lambda都使用InfiniBand。Oracle具有良好的网络,它是3200Gbps,但它是以太网而不是InfiniBand,对于高参数计数LLM训练等用例,InfiniBand可能比IB慢15-20%左右。AWS和GCP的网络就没有那么好了。企业使用哪些大云?#在一个大约15家企业的私有数据点中,所有15家都是AWS,GCP或Azure,零甲骨文。大多数企业将坚持使用现有的云。绝望的初创公司会去哪里,哪里就有供应。DGXCloud怎么样,英伟达正在与谁合作?#“NVIDIA正在与的云服务提供商合作托管DGX云基础设施,从Oracle云基础设施(OCI)开始”-您处理Nvidia的销售,但您通过现有的云提供商租用它(首先使用Oracle启动,然后是Azure,然后是GoogleCloud,而不是使用AWS启动)3233Jensen在上一次财报电话会议上表示:“理想的组合是10%的NvidiaDGX云和90%的CSP云。大云什么时候推出他们的H100预览?#CoreWeave是个。34英伟达给了他们较早的分配,大概是为了帮助加强大型云之间的竞争(因为英伟达是投资者)。Azure于13月100日宣布H<>可供预览。35甲骨文于21月100日宣布H<>数量有限。H100 GPU 提供高效的功耗管理。SMXH100GPU促销

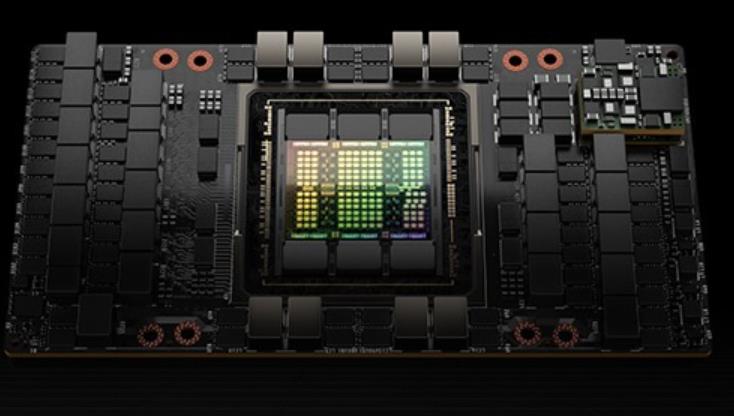

H100中新的第四代TensorCore架构提供了每SM的原始稠密和稀疏矩阵数学吞吐量的两倍支持FP8、FP16、BF16、TF32、FP64、INT8等MMA数据类型。新的TensorCores还具有更**的数据管理,节省了高达30%的操作数交付能力。FP8数据格式与FP16相比,FP8的数据存储需求减半,吞吐量提高一倍。新的TransformerEngine(在下面的章节中进行阐述)同时使用FP8和FP16两种精度,以减少内存占用和提高性能,同时对大型语言和其他模型仍然保持精度。用于加速动态规划(“DynamicProgramming”)的DPX指令新引入的DPX指令为许多DP算法的内循环提供了高等融合操作数的支持,使得动态规划算法的性能相比于AmpereGPU高提升了7倍。L1数据cache和共享内存结合将L1数据cache和共享内存功能合并到单个内存块中简化了编程,减少了达到峰值或接近峰值应用性能所需的调优;为这两种类型的内存访问提供了佳的综合性能。H100GPU层次结构和异步性改进关键数据局部性:将程序数据尽可能的靠近执行单元异步执行:寻找的任务与内存传输和其他事物重叠。目标是使GPU中的所有单元都能得到充分利用。线程块集群(ThreadBlockClusters)提出背景:线程块包含多个线程并发运行在单个SM上。xfusionH100GPU总代H100 GPU 支持 NVIDIA NVLink 技术。

H100 GPU 支持新的 PCIe 4.0 接口,提供了更高的数据传输速度和带宽,与前代 PCIe 3.0 相比,带宽提升了两倍。这使得 H100 GPU 在与主机系统通信时能够更快速地交换数据,减少了 I/O 瓶颈,进一步提升了整体系统性能。PCIe 4.0 的支持使得 H100 GPU 能够与现代主流服务器和工作站更好地兼容,充分发挥其高性能计算能力。H100 GPU 也采用了多项创新技术。其采用了先进的风冷和液冷混合散热设计,能够在高负载运行时保持稳定的温度,确保 GPU 的长期稳定运行

H100 GPU 在边缘计算中的应用也非常。其高性能计算能力和低功耗设计使其非常适合用于边缘计算。H100 GPU 的强大并行处理能力可以高效处理实时数据,提升应用的响应速度和可靠性。无论是在智能制造、智慧城市还是物联网应用中,H100 GPU 都能提升数据处理效率,满足边缘计算的需求。其紧凑设计和高能效比为边缘计算设备提供了理想的硬件支持,是边缘计算领域的重要组成部分。

ITMALL.sale 是一家专业的 H100 GPU 代理商,以其的服务和高质量的产品赢得了广大客户的信赖。作为 NVIDIA 官方授权的代理商,ITMALL.sale 提供全系列的 H100 GPU 产品,确保客户能够获得、的图形处理器。无论是企业级应用还是个人用户,ITMALL.sale 都能够提供个性化的解决方案,满足不同客户的需求。ITMALL.sale 不仅提供产品销售,还为客户提供的技术支持和售后服务,确保客户在使用 H100 GPU 过程中无后顾之忧。 H100 GPU 支持 Tensor Core 技术。

H100GPU层次结构和异步性改进关键数据局部性:将程序数据尽可能的靠近执行单元异步执行:寻找的任务与内存传输和其他事物重叠。目标是使GPU中的所有单元都能得到充分利用。线程块集群(ThreadBlockClusters)提出背景:线程块包含多个线程并发运行在单个SM上,这些线程可以使用SM的共享内存与快速屏障同步并交换数据。然而,随着GPU规模超过100个SM,计算程序变得更加复杂,线程块作为编程模型中***表示的局部性单元不足以大化执行效率。Cluster是一组线程块,它们被保证并发调度到一组SM上,其目标是使跨多个SM的线程能够有效地协作。GPC:GPU处理集群,是硬件层次结构中一组物理上总是紧密相连的子模块。H100中的集群中的线程在一个GPC内跨SM同时运行。集群有硬件加速障碍和新的访存协作能力,在一个GPC中SM的一个SM-to-SM网络提供集群中线程之间快速的数据共享。分布式共享内存(DSMEM)通过集群,所有线程都可以直接访问其他SM的共享内存,并进行加载(load)、存储(store)和原子(atomic)操作。SM-to-SM网络保证了对远程DSMEM的快速、低延迟访问。在CUDA层面。集群中所有线程块的所有DSMEM段被映射到每个线程的通用地址空间中。H100 GPU 适用于人工智能训练任务。Iran模组H100GPU

H100 GPU 配备 80GB 的 HBM2e 高带宽内存。SMXH100GPU促销

硬件方面的TPU,Inferentia,LLMASIC和其他产品,以及软件方面的Mojo,Triton和其他产品,以及使用AMD硬件和软件的样子。我正在探索一切,尽管专注于***可用的东西。如果您是自由职业者,并希望帮助Llama2在不同的硬件上运行,请给我发电子邮件。到目前为止,我们已经在AMD,Gaudi上运行了TPU和Inferentia,并且来自AWSSilicon,R**n,Groq,Cerebras和其他公司的人员提供了帮助。确认#本文包含大量专有和以前未发布的信息。当您看到人们对GPU生产能力感到疑惑时,请向他们指出这篇文章的方向。感谢私有GPU云公司的少数高管和创始人,一些AI创始人,ML工程师,深度学习研究员,其他一些行业和一些非行业读者,他们提供了有用的评论。感谢哈米德的插图。A100\H100基本上越来越少,A800目前也在位H800让路,如果确实需要A100\A800\H100\H800GPU,建议就不用挑剔了,HGX和PCIE版对大部分使用者来说区别不是很大,有货就可以下手了。无论如何,选择正规品牌厂商合作,在目前供需失衡不正常的市场情况下,市面大部分商家是无法供应的,甚至提供不属实的信息。SMXH100GPU促销

上一篇: N9K-C9508 多少钱

下一篇: N9K-C9516-FM-CV 总代